一站传媒领先的互联网解决方案提供商!

客服手机/微信 :

14715991665

客服手机/微信 :

14715991665

??新智元报道??

编辑:好困

【新智元导读】中科大王杰教授团队提出局部消息补偿技术,解决采样子图边缘节点邻居缺失问题,弥补图神经网络(GNNs)子图采样方法缺少收敛性证明的空白,推动 GNNs 的可靠落地。

图神经网络(Graph 采用的方式就是大量注册每个平台的账号,通过提问和回答的方式去塑造自己的企业多么多么好,多么多么靠谱等等。当后期用户在网上浏览这些信息之后,相当于你从第三方的角度推荐自己的企业,这时候自己的口碑也就上来了,当有了一批种子客户之后,后期就可以,达到上面所聊到了转介绍的作用。而企业的口碑塑造是需要常年累积的,而不是一天两天或者一个月两个月就可以见效的,就好比锦随推这边自己就是做口碑问答推广的。我们自己每个月都会做些相关的问答来宣传自己的业务。 Neural Networks,简称 GNNs)是处理图结构数据的最有效的机器学习模型之一,也是顶会论文的香饽饽。

然而,GNNs 的计算效率一直是个硬伤,在大规模图数据上训练 GNNs 常常会遇上邻居爆炸(neighbor explosion)问题——节点表示和随机梯度的计算复杂度会随着图神经网络层数的增加而指数上升。

很多 GNNs 的学术研究都会倾向于选择小规模图数据集(千量级节点数)进行实验,避开 GNNs 的计算效率问题。但是,这一问题在工业界实际落地的场景中无法避免:在大规模图数据(十亿节点)[3] 上,这些 GNNs 根本无法运行。

一个最简单粗暴的办法是:在每次模型训练或预测的时候,从全量图上切出一个子图,在子图上运行 GNNs。这又会带新的问题:在子图上训练的 GNNs 能和全量图上训练的 GNNs 一样吗?子图边缘节点会不会丢失很多邻居信息?

为此,中科大 MIRA Lab 王杰教授团队提出了一种 GNNs 的子图采样训练方法——本地消息补偿(Local Message Compensation,简称 LMC)。

LMC 具有极低的计算开销;并且,理论证明:LMC 在子图上训练的 GNNs 的性能可媲美在全量图上训练的 GNNs,同时 LMC 能加速 GNNs 收敛。相关成果论文已被 ICLR 2023 接收为 Spotlight。

采用的方式就是大量注册每个平台的账号,通过提问和回答的方式去塑造自己的企业多么多么好,多么多么靠谱等等。当后期用户在网上浏览这些信息之后,相当于你从第三方的角度推荐自己的企业,这时候自己的口碑也就上来了,当有了一批种子客户之后,后期就可以,达到上面所聊到了转介绍的作用。而企业的口碑塑造是需要常年累积的,而不是一天两天或者一个月两个月就可以见效的,就好比锦随推这边自己就是做口碑问答推广的。我们自己每个月都会做些相关的问答来宣传自己的业务。

作者列表:石志皓,梁锡泽,王杰

论文链接:https://openreview.net/forum?id=5VBBA91N6n

1. 引言

基于消息传递机制的图神经网络(GNNs)在许多实际应用中取得了巨大成功。然而,在大规模图上训练 GNNs 会遇到众所周知的邻居爆炸(neighbor explosion)问题——节点的依赖性随消息传递层的数量呈指数增长。

子图采样方法——一类备受瞩目的小批量训练(mini-batch training)技术——在反向传播中丢弃小批量之外的消息,以此避免邻居爆炸问题,但同时以牺牲梯度估计的精度为代价。这对它们的收敛性分析和收敛速度都提出了重大挑战,严重限制了它们在现实场景中的进一步应用。

为了应对这些挑战,我们提出了一种具有收敛性保证的新型子图采样方法——本地消息补偿(Local Message Passing,简称 LMC)。据我们所知,LMC 是首个具有可证明收敛性的子图采样方法。

LMC 的关键思想是基于反向传播传递的消息传递建模来恢复在反向传播中被丢弃的消息。通过对正向和反向传播中丢弃的消息进行高效和有效的补偿,LMC 计算出准确的小批量梯度,从而加速收敛。

进一步地,我们证明了 LMC 收敛到 GNNs 的一阶驻点(first-order stationary points)。在大规模基准测试任务中的实验表明,LMC 在效率方面明显优于最先进的子图采样方法。

2. 背景与问题

2.1 图神经网络

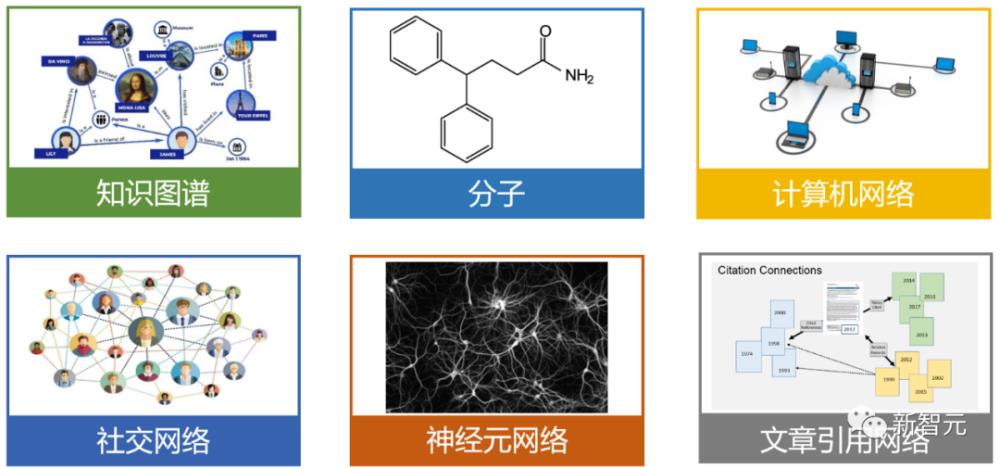

在实际问题中,图结构数据随处可见,例如知识图谱、分子、计算机网络、社交网络、神经元网络、文章引用网络等,如图1所示。

图1. 图结构数据在实际问题中随处可见,图中展示了各式各样的图数据。

图神经网络(Graph Neural Networks,简称 GNNs)通过消息传递范式?[1] 处理图数据,是当前处理图结构数据最有效的机器学习模型之一。在每个消息传递层中,GNNs 迭代地聚合邻居节点的消息,以更新当前节点的表示。这种范式在许多实际应用中取得了巨大的成功,例如搜索引擎 [2]、推荐系统 [3]、材料工程 [4]、分子性质预测 [5, 6],以及组合优化 [7]。

具体地,以半监督的结点分类任务为例,GNNs 旨在通过最小化目标函数??来学习结点嵌入??以及参数?,其中?,?是有标签结点的集合,?是参数为??的输出层与一个损失函数的组合,?是结点??的嵌入,?是结点??的标签,?是结点特征,?是图上所有边的集合。

一个??层的 GNN 通过??次有着不同参数??的消息传递迭代来生成最终的结点嵌入?:

其中?,?是第??层的消息传递函数,参数为?。

消息传递函数? 遵循聚合-更新机制,即

其中??是为结点??的每个邻居生成消息的函数,?是将邻居消息集合映射到最终消息??的聚合函数,?是组合从前的结点嵌入?,消息?,以及结点特征??的更新函数。

2.2 邻居爆炸

尽管 GNNs 在许多应用中取得了巨大的成功,这种消息迭代机制也给 GNNs 在大规模图数据上的训练带来了挑战。

使用有限的 GPU 内存将深度模型扩展到任意大规模数据的一种常见方法是通过小批量梯度近似全批次梯度。然而,对于图结构数据,由于众所周知的邻居爆炸问题,计算小批量节点的损失函数和相应的小批量梯度的成本是非常昂贵的。

具体地,对于 GNNs 而言,一个结点在第??层消息传递中的嵌入递归地依赖于它邻居在第??层的嵌入。因此,计算复杂度会随着消息传递层数的增加而指数级上涨,带来无法令人接受的计算开销。

2.3 子图采样方法

为了解决邻居爆炸问题,最近的一些工作提出了各种各样的采样技术以减少消息传递所牵涉的节点个数。例如,结点采样方法 [8, 9] 和层采样方法 [10, 11, 12] 会在消息传递中递归地采样邻居,从而估计结点嵌入以及对应的小批量梯度。

与这种递归的范式不同,子图采样方法?[13, 14, 15, 16] 使用了一种更为简单、成本低廉的一次性采样范式(one-shot sampling fashion)——为不同的消息传递层采样同一个子图,该子图由同一小批量结点所构建。

通过丢弃小批量之外的消息,子图采样方法将消息传递过程限制在小批量中,使得复杂度随消息传递层数的增加而线性增长,极大降低了计算开销。此外,通过直接在子图上运行 GNNs,子图采样方法适用于非常广泛的 GNN 结构。由于上述优势,子图采样方法近期收到了越来越多的关注。

然而,子图采样方法这种丢弃小批量外部消息的做法牺牲了梯度估计的精度,这给它们的收敛性分析和收敛速度带来了极大挑战:

首先,近期工作 [9, 17] 表明,不准确的小批量梯度会严重降低 GNNs 的收敛速度。

其次,我们的实验表明,现有子图采样方法在批量大小较小时难以达到全梯度下训练的表现;而我们在实际应用中经常会将批量大小设置为一个较小的数字,以避免超出 GPU 的显存。

对此,我们发问:能否设计一个子图采样方法,它既有极低的计算开销,又有媲美全梯度训练的预测精度,同时还有严格的收敛性保证?

我们的回答是:LMC 能做到!

3. 方法:局部信息补偿 LMC

我们的研究思路受到了 VR-GCN [9] 的启发,其主要抓手是把节点或层级别的递归采样看成一个无偏的基线方法——Standard SGD的近似,进而通过对于梯度的误差分析来证明收敛性。

然而,很难把子图采样方法看成 Standard SGD 的近似,因为子图采样在每一层都采样相同的子图,每一层的计算都会引入不可避免的偏差。因此,我们第一步是先提出一个 Backward SGD,它更便于我们的分析子图采样这种一次性采样范式。在 Backward SGD 的基础上,我们分析如何给子图采样方法加入合适的补偿项,减少它的偏差,进而找到一个可证明收敛的子图采样算法。

3.1 将反向传播建模为消息传递

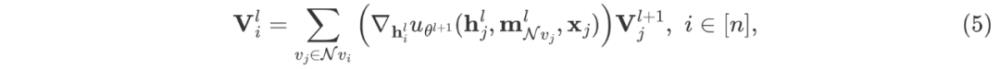

梯度??是容易计算的,所以我们主要介绍如何计算?。令?,?为辅助变量,则有?。由链式法则,我们能够基于??迭代地计算?:

以及

然后,我们可以使用处理向量-Jacobian 积的自动求导工具来计算梯度?。

我们将反向传播(即迭代计算方程 (3)?的过程)建模为消息传递。为了看到这一点,我们只需注意到 (3)?等价于

其中??是??的第??列。方程 (5) 分别使用?、求和聚合,以及恒等映射作为生成函数、聚合函数,以及更新函数。

3.2 LMC 的基石:Backward SGD

基于这一反向传播的消息传递建模,我们设计了一个 SGD 变体——Backward SGD,它能带来无偏的梯度估计。需要说明的是,Backward?SGD 是我们主要方法 LMC 的基石。

给定一个被采样的小批量?,假设我们已经获得了小批量中结点的准确嵌入??和准确辅助变量?。读者需要注意:这一假设是比较强的,事实上我们很难计算准确的嵌入和辅助变量。下一节介绍的主要方法 LMC 所做的就是利用子图采样来估计结点嵌入和辅助变量。

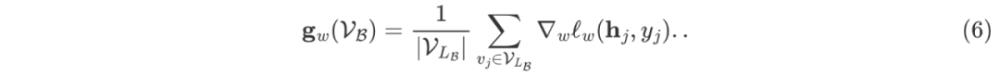

首先,Backward?SGD 计算参数??的小批量梯度?:

然后,Backward?SGD 计算参数??的小批量梯度?:

注意到:对于不同的层数?,小批量梯度??牵涉的小批量是同一个(即?),这就给基于 Backward?SGD 设计子图采样方法提供了基础。

Backward?SGD 的另一个吸引人的性质是:小批量梯度??和??是无偏的,如第4节中的定理1所示。详细的证明请参见原论文附录。

3.3 本地消息补偿 LMC

在上一节中,Backward?SGD 所计算的小批量梯度依赖于小批量中节点的准确嵌入和准确辅助变量,而不是整张图。然而,Backward?SGD 仍然不是可扩展的(scalable),因为邻居爆炸问题会使得准确结点嵌入和辅助变量的计算极其昂贵,所以事实上我们无法得到准确的??和?。

在这一节中,为了解决邻居爆炸问题,我们提出了新颖的子图采样方法——本地消息补偿(Local Message Compensation,简称 LMC)。

LMC 首先通过不完全最新值(incomplete up-to-date values)和历史值(historical values)的凸组合来高效地估计??和?,然后利用方程 (6)?和 (7)?计算小批量梯度。在之后的理论分析中,我们证明了 LMC 收敛到 GNNs 的一阶驻点。在算法1和理论分析中,我们用??表示一个第??层、第??次迭代时的量,而在其他地方我们省略上标?,用??来表示。

在每个训练迭代中,我们采样一个小批量结点?,通过历史值?和?,以及不完全最新值和??的凸组合来高效地估计??和?。

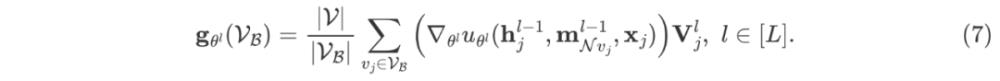

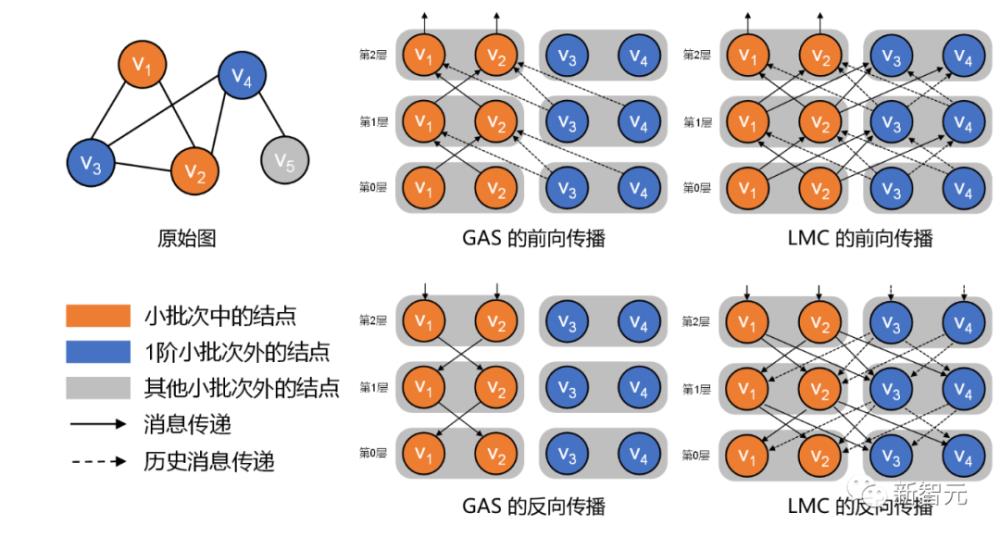

为便于读者理解方法的核心思想,我们将 LMC 与现有最先进方法 GAS [15] 的前向传播、反向传播计算图展示在图2。

图2. LMC 与 GAS 前向传播与反向传播的计算图。可以看到,在前向传播和反向传播中,LMC 均进行了小批量结点与一跳邻居之间的消息交互(即补偿),而 GAS 在反向传播中丢弃了小批量之外的消息。

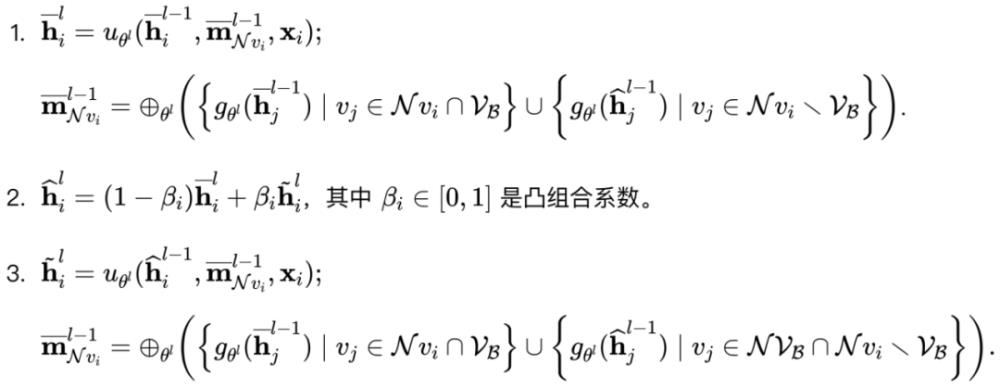

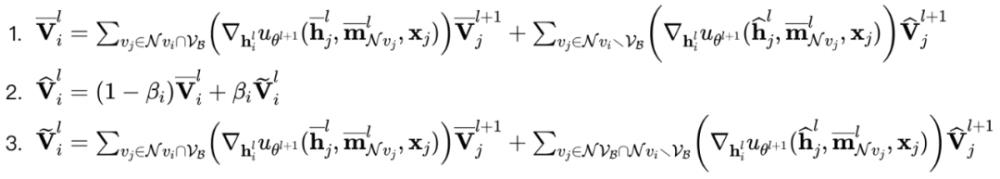

在前向传播中,我们将??的?临时嵌入设为?,然后以??的顺序更新??中的历史嵌入?。特别地,在第??层,我们进行以下计算:

在反向传播中,我们将??的临时辅助变量设为?,然后以??的顺序更新?中的历史辅助变量?。特别地,在第??层,我们进行以下计算:

关于方法的具体细节、详细解释、计算复杂度分析等,请读者参见原论文。

我们分别称??和?为第??层前向传播和反向传播的本地消息补偿。

4.理论分析

理论分析包含三个主要定理。从直观(说人话)的角度,它们分别在说:

定理1:Backward SGD 的梯度是无偏的。这样,我们就基本可以保证 Backward SGD 的收敛性。

定理2:LMC 所估计的梯度和 Backward SGD 的梯度相差不大,能够被我们给出的上界所控制。

定理3:LMC 收敛到 GNNs 的一阶驻点,这也是我们的最终定理。

理论部分的核心思想是:LMC 和 Backward SGD 的收敛行为一致。

在本节中,我们做如下假设:

在第??个迭代中,小批量节点??是从??中均匀采样的,对应的有标签节点集??是从??中采样的。

函数?,?,?,?,?,??是?-Lipschitz 连续的,其中?。

范数?,?,?,?,?,?,?,?,?,?,?,??被常数??所控制。

定理1.?假设一个小批量??是从结点集合??中均匀采样的,并且对应的有标签结点集合??也是从??中均匀采样的,则方程 (6) 和 (7)??所计算的小批量梯度??和??是无偏的。

定理2. 在上述假设下,令??和?,存在??和??使得

定理3.?在上述假设下,再假定最优值??被??控制。令?,,以及?,LMC 可保证在??次迭代后找到一个?-驻点使得?,其中??是随机从??中选取的,。

5. 实验

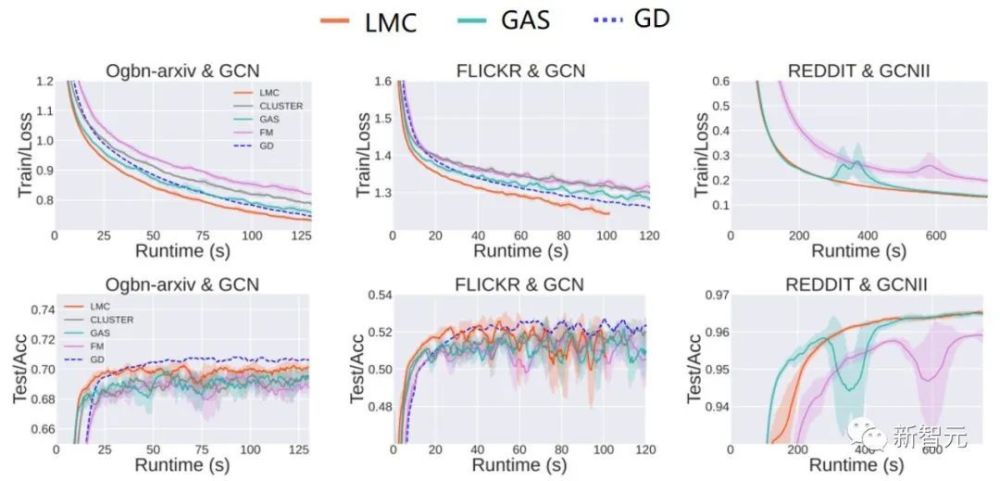

在实验部分,我们做了4个大数据集的实验,图3列出了其中3个。LMC 的训练集 loss 的收敛速度超过了所有其他方法,但是测试集上有个众所周知的泛化问题,尽管 LMC 在训练集上收敛快,但模型很快就过拟合了,所以 LMC 在测试集的准确率曲线提升看起来并不如训练集明显。

我们发现,LMC 最终的预测准确率和 SOTA 方法 GAS 相差不大,这是因为 early stopping 技术,即在训练过程中,测试集的曲线是震荡的,early stopping 汇报的大概率是测试集准确率曲线的最大值。为了突出训练过程中波动性的影响,我们在图3汇报的曲线用滑动窗口取了平均值构成实线,标准差构成阴影部分。可以看出,LMC 在训练稳定性上明显超过 GAS。GAS 和 LMC 最终预测准确率的差距会在 batch size 比较小的情况下有所体现(图6),这时 METIS 的作用会被削弱。

图3. 收敛时间对比

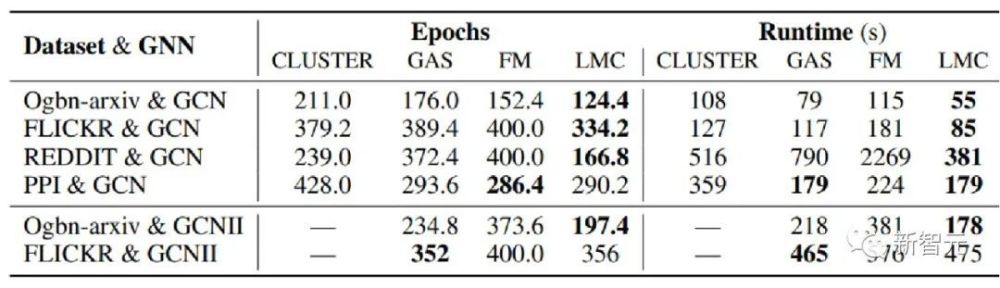

我们进一步统计达到一个给定测试集准确率的时间。我们先跑一个全梯度 GD,得到它的最高测试集准确率,然后再分别运行几种子图采样方法,计算达到这一准确率需要的时间。在 REDDIT 数据集上,LMC 相对于 GAS 的加速比达到2倍。

图4. 达到最高测试集准确率时间对比

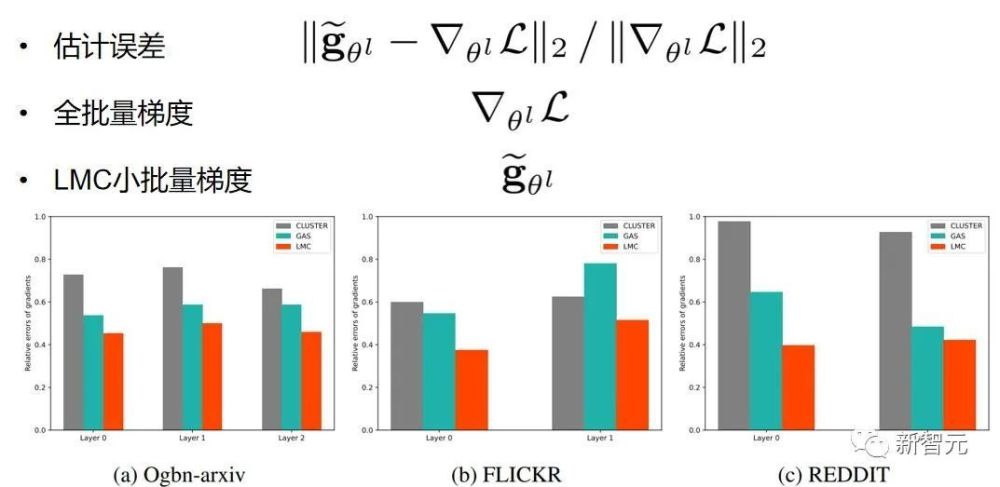

更进一步,LMC 的梯度估计和 Backward?SGD 差不多,所以梯度估计是更准确的。我们这里统计了计算过程中的相对误差,如图5所示,确实是 LMC 的估计误差最小。

图5. 相对误差对比

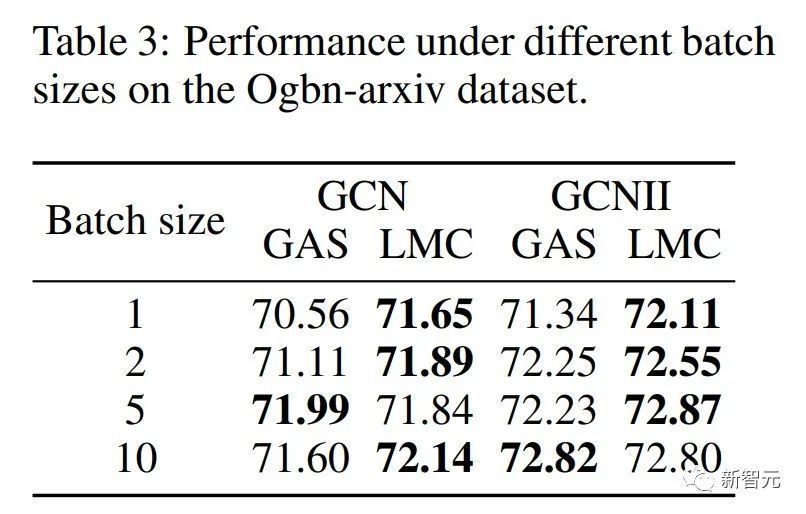

进一步做了 small batch size 下的实验,前面在子图采样算法中举了一个例子,子图规模很小的话,丢弃的节点就很多,很容易达到次优。如表三所示,我们的方法对 batch size 更加鲁棒,因此在计算资源受限的情景下,LMC的优势会更加明显。

图6. 不同批量大小的表现

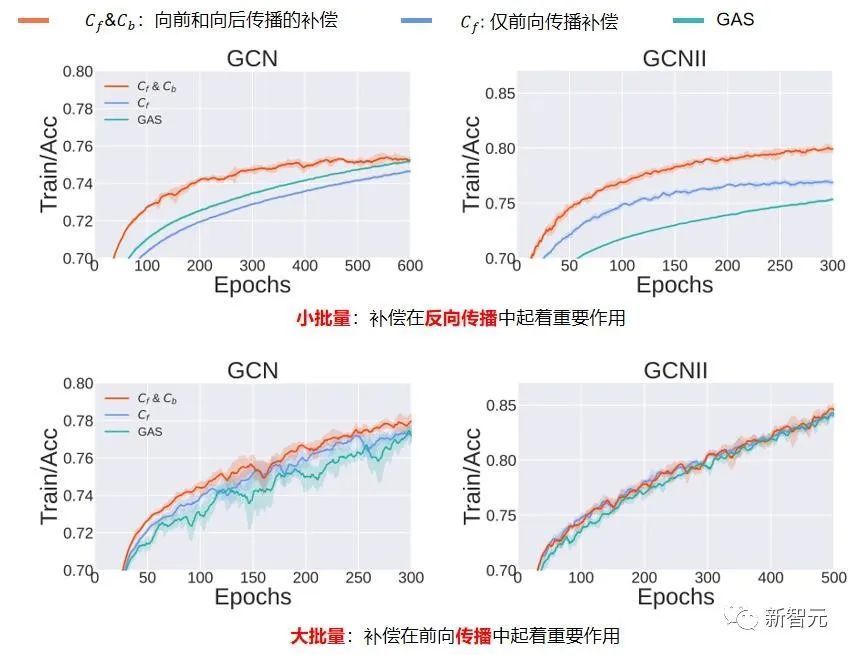

最后是消融实验,相对于 SOTA 的 GAS 方法,我们对前向传播过程的补偿消息进行了改进,并且在反向传播也加入了一个补偿。如图7所示,我们发现,在batch size很小的情况下,反向传播的补偿很重要,因为这一 设定下,丢弃了很多消息,导致收敛到次优解。在batch size较大的时候,采样子图一阶邻居是很大的,我们通过采样子图一阶邻居内部的消息传递,提高了历史信息的准确率,也能提高子图采样算法的性能。

图7. 消融实验

参考资料:

[1] Hamilton, William L. "Graph representation learning." Synthesis Lectures on Artifical Intelligence and Machine Learning 14.3 (2020): 1-159.

[2] Brin, Sergey, and Lawrence Page. "The anatomy of a large-scale hypertextual web search engine." Computer networks and ISDN systems 30.1-7 (1998): 107-117.

[3] Fan, Wenqi, et al. "Graph neural networks for social recommendation." The world wide web conference. 2019.

[4] Gostick, Jeff, et al. "OpenPNM: a pore network modeling package." Computing in Science & Engineering

18.4 (2016): 60-74.

[5] Moloi, N. P., and M. M. Ali. "An iterative global optimization algorithm for potential energy minimization." Computational Optimization and Applications 30 (2005): 119-132.

[6] Kearnes, Steven, et al. "Molecular graph convolutions: moving beyond fingerprints." Journal of computer-aided molecular design 30 (2016): 595-608.

[7] Wang, Zhihai, et al. "Learning Cut Selection for Mixed-Integer Linear Programming via Hierarchical Sequence Model." arXiv preprint arXiv:2302.00244 (2023).

[8] Hamilton, Will, Zhitao Ying, and Jure Leskovec. "Inductive representation learning on large graphs." Advances in neural information processing systems 30 (2017). [9] Chen, Jianfei, Jun Zhu, and Le Song. "Stochastic training of graph convolutional networks with variance reduction." arXiv preprint arXiv:1710.10568 (2017).

[10] Chen, Jie, Tengfei Ma, and Cao Xiao. "Fastgcn: fast learning with graph convolutional networks via importance sampling." arXiv preprint arXiv:1801.10247 (2018).

[11] Zou, Difan, et al. "Layer-dependent importance sampling for training deep and large graph convolutional networks." Advances in neural information processing systems 32 (2019).

[12] Huang, Wenbing, et al. "Adaptive sampling towards fast graph representation learning." Advances in neural 采用的方式就是大量注册每个平台的账号,通过提问和回答的方式去塑造自己的企业多么多么好,多么多么靠谱等等。当后期用户在网上浏览这些信息之后,相当于你从第三方的角度推荐自己的企业,这时候自己的口碑也就上来了,当有了一批种子客户之后,后期就可以,达到上面所聊到了转介绍的作用。而企业的口碑塑造是需要常年累积的,而不是一天两天或者一个月两个月就可以见效的,就好比锦随推这边自己就是做口碑问答推广的。我们自己每个月都会做些相关的问答来宣传自己的业务。 information processing systems 31 (2018).

[13] Chiang, Wei-Lin, et al. "Cluster-gcn: An efficient algorithm for training deep and large graph convolutional networks." Proceedings of the 25th ACM SIGKDD international conference on knowledge discovery & data mining. 2019.

[14] Zeng, Hanqing, et al. "Graphsaint: Graph sampling based inductive learning method." arXiv preprint arXiv:1907.04931 (2019).

[15] Fey, Matthias, et al. "Gnnautoscale: Scalable and expressive graph neural networks via historical embeddings." International Conference on Machine Learning. PMLR, 2021.

[16] Zeng, Hanqing, et al. "Decoupling the depth and scope of graph neural networks." Advances in Neural Information Processing Systems 34 (2021): 19665-19679.

[17] Cong, Weilin, et al. "Minimal variance sampling with provable guarantees for fast training of graph neural networks." Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. 2020.

关键词:问答论坛代发建筑建木板料行业,问答论坛代发多少钱

发布时间:2023-03-27

来源:一站传媒

责任编辑:李伍

代做问答论坛工厂实体店行业2023已更新(滚动/网选)

↑点击上方“现代教育报”即可关注我们问答营销推广应长期进行并定时整理。每天回答问题的网络营销数量不宜...

代做问答论坛有效处理2023已更新(行业/看点)

来源:河北网络安全编辑/一审:马静思二审:宋培元三审:随永明网信清河培养后也不能大量发布携带广告信息的,大量发...

代做问答论坛体育比赛器材行业2023已更新(行业/图文)

国家安全是民族复兴的根基社会稳定是国家强盛的前提问答发布完成后,还需要对发布的内容进行观察一段时间,期间...

问答营销发布教育培训艺术行业2023已更新(深度/互动)

(来源:黑龙江省住建厅)导读:本文件规定了黑龙江省建设工程质量检测机构现场检测技术管理的术语和定义、基本规定...

代做问答论坛APP软件游戏行业2023已更新(精选/头条)

(甘肃省兰州市七里河北街143号)问题的设计和技巧:在这里,要强调一下,问答,是我们自问自答,事前都设计好关键字的...

问答论坛代发体育比赛器材行业2023已更新(近期/快讯)

【悟空问答、天涯问答等,不同的问答效果都不一样,口碑问答营销可以全渠道投放,这样你可以获得更多潜在客户的可...

代做问答论坛渠道2023已更新(近期/预告)

会展业是现代科学技术与经济发展的晴雨表,它反映了一个国家、地区乃至全球科学技术和经济发展的历程。从20世...

问答营销发布平台2023已更新(滚动/资讯)

终于得知顶替真相的高加林,能够原谅昔日挚友的欺骗吗?创业受挫的刘巧珍,下一步将走向何方?随母亲出国的黄亚萍,与...

知道贴吧代发怎么做2023已更新(分类/专栏)

新華社記者魏培全攝新華社記者羅曉光攝本報電(記者趙曉霞)國家文物局日前印發通知,啟動《中國世界文化遺產預備...

代做问答论坛农产品水果行业2023已更新(最新/推荐)

4月10日《人民日报海外版》旅游天地版头条刊文聚焦多元丽江金沙江、怒江、澜沧江三条“世界级”河流,从青藏...

知道贴吧代发餐饮房地产行业2023已更新(最新/网评)

南宋诗人赵葵有诗云:“一抹轻烟隔小桥,新篁摇翠两三梢。惜春不觉归来晚,花压重门带月敲。”描写了外出踏青者因...

代做问答论坛价格2023已更新(地方/研究)

近日,手机品牌酷派官方宣布回归市场,并带来了三款新机:COOL30、锋尚40和大观40S。其中,大观40S已经上架酷派官网...

Copyright 2008-2023 一站传媒 One station media 严禁抄袭镜像本站 违者依法追究责任!

粤ICP备14083186号-3

![]()

广东省 广州市 深圳市 珠海市 汕头市 佛山市 韶关市 湛江市 肇庆市 江门市 茂名市 惠州市 梅州市 汕尾市 河源市 阳江市 清远市 东莞市 中山市 潮州市 揭阳市 云浮市 河南省 郑州市 洛阳市 焦作市 商丘市 信阳市 周口市 鹤壁市 安阳市 濮阳市 驻马店市 南阳市 开封市 漯河市 许昌市 新乡市 济源市 灵宝市 偃师市 邓州市 登封市 三门峡市 新郑市 禹州市 巩义市 永城市 长葛市 义马市 林州市 项城市 汝州市 荥阳市 平顶山市 卫辉市 辉县市 舞钢市 新密市 孟州市 沁阳市 安徽省 合肥市 亳州市 芜湖市 马鞍山市 池州市 黄山市 滁州市 安庆市 淮南市 淮北市 蚌埠市 宿州市 宣城市 六安市 阜阳市 铜陵市 明光市 天长市 宁国市 界首市 桐城市 潜山市 福建省 福州市 厦门市 泉州市 漳州市 南平市 三明市 龙岩市 莆田市 宁德市 龙海市 建瓯市 武夷山市 长乐市 福清市 晋江市 南安市 福安市 邵武市 石狮市 福鼎市 建阳市 漳平市 永安市 甘肃省 兰州市 白银市 武威市 金昌市 平凉市 张掖市 嘉峪关市 酒泉市 庆阳市 定西市 陇南市 天水市 玉门市 临夏市 合作市 敦煌市 甘南州 贵州省 贵阳市 安顺市 遵义市 六盘水市 兴义市 都匀市 凯里市 毕节市 清镇市 铜仁市 赤水市 仁怀市 福泉市 海南省 海口市 三亚市 万宁市 文昌市 儋州市 琼海市 东方市 五指山市 河北省 石家庄市 保定市 唐山市 邯郸市 邢台市 沧州市 衡水市 廊坊市 承德市 迁安市 鹿泉市 秦皇岛市 南宫市 任丘市 叶城市 辛集市 涿州市 定州市 晋州市 霸州市 黄骅市 遵化市 张家口市 沙河市 三河市 冀州市 武安市 河间市 深州市 新乐市 泊头市 安国市 双滦区 高碑店市 黑龙江省 哈尔滨市 伊春市 牡丹江市 大庆市 鸡西市 鹤岗市 绥化市 齐齐哈尔市 黑河市 富锦市 虎林市 密山市 佳木斯市 双鸭山市 海林市 铁力市 北安市 五大连池市 阿城市 尚志市 五常市 安达市 七台河市 绥芬河市 双城市 海伦市 宁安市 讷河市 穆棱市 同江市 肇东市 湖北省 武汉市 荆门市 咸宁市 襄阳市 荆州市 黄石市 宜昌市 随州市 鄂州市 孝感市 黄冈市 十堰市 枣阳市 老河口市 恩施市 仙桃市 天门市 钟祥市 潜江市 麻城市 洪湖市 汉川市 赤壁市 松滋市 丹江口市 武穴市 广水市 石首市大冶市 枝江市 应城市 宜城市 当阳市 安陆市 宜都市 利川市 吉林省 长春市 吉林市 通化市 白城市 四平市 辽源市 松原市 白山市 集安市 梅河口市 双辽市 延吉市 九台市 桦甸市 榆树市 蛟河市 磐石市 大安市 德惠市 洮南市 龙井市 珲春市 公主岭市 图们市 舒兰市 和龙市 临江市 敦化市 江苏省 南京市 无锡市 常州市 扬州市 徐州市 苏州市 连云港市 盐城市 淮安市 宿迁市 镇江市 南通市 泰州市 兴化市 东台市 常熟市 江阴市 张家港市 通州市 宜兴市 邳州市 海门市 溧阳市 泰兴市 如皋市 昆山市 启东市 江都市 丹阳市 吴江市 靖江市 扬中市 新沂市 仪征市 太仓市 姜堰市 高邮市 金坛市 句容市 灌南县 海安市 江西省 南昌市 赣州市 上饶市 宜春市 景德镇市 新余市 九江市 萍乡市 抚州市 鹰潭市 吉安市 丰城市 樟树市 德兴市 瑞金市 井冈山市 共青城市 高安市 乐平市 南康市 贵溪市 瑞昌市 辽宁省 沈阳市 葫芦岛市 大连市 盘锦市 鞍山市 铁岭市 本溪市 丹东市 抚顺市 锦州市 辽阳市 阜新市 调兵山市 朝阳市 海城市 北票市 盖州市 凤城市 庄河市 凌源市 开原市 兴城市 新民市 大石桥市 东港市 北宁市 瓦房店市 普兰店市 凌海市 灯塔市 营口市 青海省 西宁市 玉树市 格尔木市 德令哈市 山东省 济南市 青岛市 威海市 潍坊市 菏泽市 济宁市 东营市 烟台市 淄博市 枣庄市 泰安市 临沂市 日照市 德州市 聊城市 滨州市 乐陵市 兖州市 诸城市 邹城市 滕州市 肥城市 新泰市 胶州市 胶南市 龙口市 平度市 莱西市 山西省 太原市 大同市 阳泉市 长治市 临汾市 晋中市 运城市 忻州市 朔州市 吕梁市 古交市 高平市 永济市 孝义市 侯马市 霍州市 介休市 河津市 汾阳市 原平市 晋城市 潞城市 陕西省 西安市 咸阳市 榆林市 宝鸡市 铜川市 渭南市 汉中市 安康市 商洛市 延安市 韩城市 兴平市 华阴市 四川省 成都市 广安市 德阳市 乐山市 巴中市 内江市 宜宾市 南充市 都江堰市 自贡市 泸州市 广元市 达州市 资阳市 绵阳市 眉山市 遂宁市 雅安市 阆中市 攀枝花市 广汉市 绵竹市 万源市 华蓥市 江油市 西昌市 彭州市 简阳市 崇州市 什邡市 峨眉山市 邛崃市 云南省 昆明市 玉溪市 大理市 曲靖市 昭通市 保山市 丽江市 临沧市 楚雄市 开远市 个旧市 景洪市 安宁市 宣威市 文山市 普洱市 浙江省 杭州市 宁波市 绍兴市 温州市 台州市 湖州市 嘉兴市 金华市 舟山市 衢州市 丽水市 余姚市 乐清市 临海市 温岭市 永康市 瑞安市 慈溪市 义乌市 上虞市 诸暨市 海宁市 桐乡市 兰溪市 龙泉市 建德市 富德市 富阳市 平湖市 东阳市 嵊州市 奉化市 临安市 江山市 广西 南宁市 贺州市 玉林市 桂林市 柳州市 梧州市 北海市 钦州市 百色市 防城港市 贵港市 河池市 崇左市 来宾市 东兴市 桂平市 北流市 岑溪市 合山市 凭祥市 宜州市 内蒙古 呼和浩特市 呼伦贝尔市 赤峰市 扎兰屯市 鄂尔多斯市 乌兰察布市 巴彦淖尔市 二连浩特市 霍林郭勒市 包头市 乌海市 阿尔山市 乌兰浩特市 锡林浩特市 根河市 满洲里市 额尔古纳市 牙克石市 临河市 丰镇市 通辽市 西藏 拉萨市 那曲市 山南市 林芝市 昌都市 阿里地区 日喀则市 宁夏 银川市 固原市 石嘴山市 青铜峡市 中卫市 吴忠市 灵武市 新疆 乌鲁木齐市 石河子市 喀什市 阿勒泰市 阜康市 库尔勒市 阿克苏市 阿拉尔市 哈密市 克拉玛依市 昌吉市 奎屯市 米泉市 和田市 塔城市 北京市 天津市 重庆市 上海市